英伟达称 Blackwell Ultra 为 AI 带来 50 倍性能提升

英伟达 发布的最新基准测试数据显示,其搭载 Blackwell Ultra GPU 的 GB300 NVL72 系统在低延迟 AI 工作负载中,每兆瓦吞吐量提升高达 50 倍,每 token 成本相比该公司上一代 Hopper 平台降低 35 倍。这些性能提升使该硬件成为快速扩张的智能体 AI 应用和编码助手市场的领先解决方案。

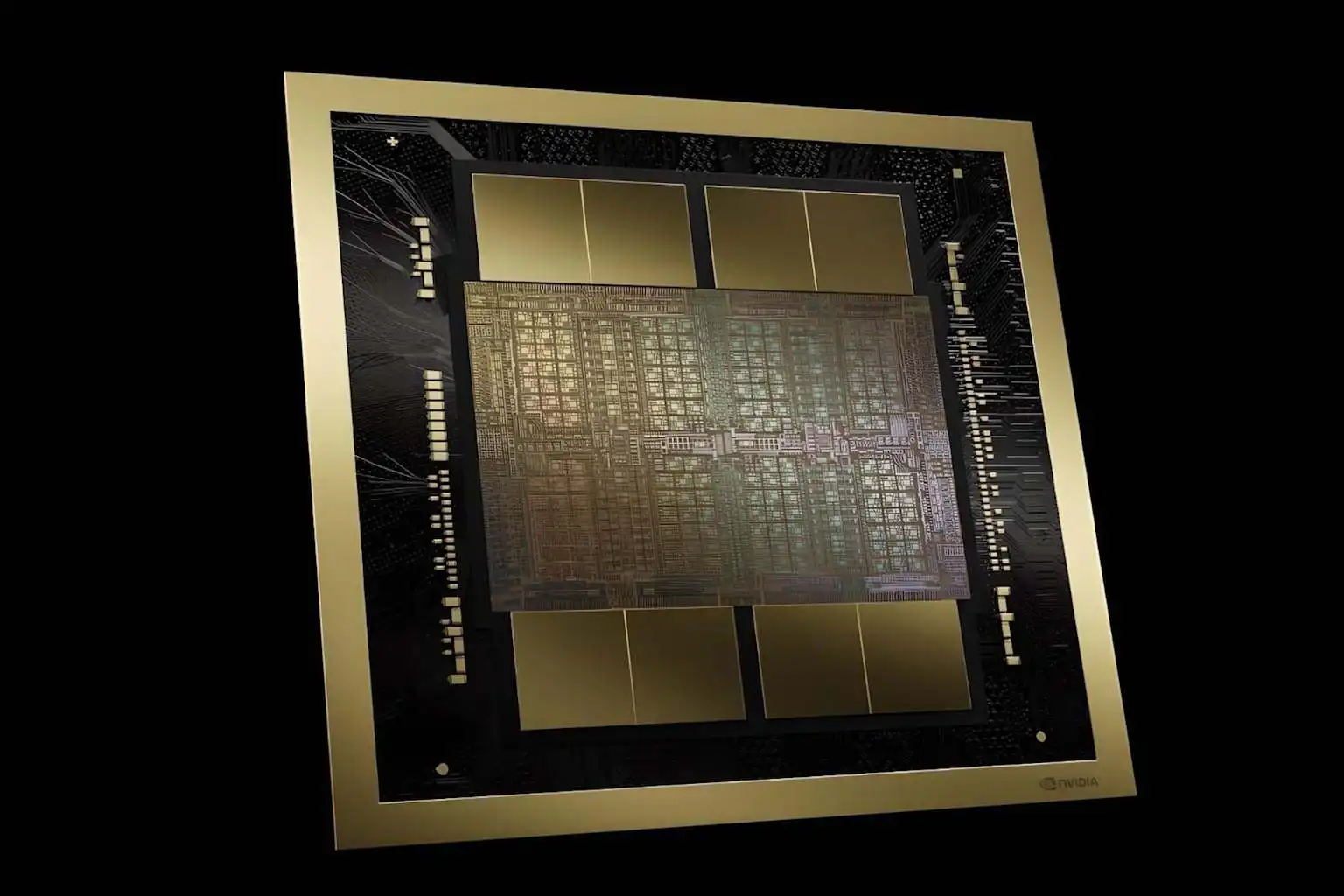

架构改进推动性能提升

这一性能飞跃源于硬件进步与持续软件优化的结合。根据英伟达开发者博客,Blackwell Ultra Tensor Cores(超级张量核心)相比标准Blackwell GPU提供了1.5倍的计算性能,同时通过加速softmax执行,注意力层处理速度提升了一倍。这些架构改进直接解决了推理模型在处理大上下文窗口时所依赖的transformer注意力层的瓶颈问题。

该公司的TensorRT-LLM推理库在近几个月中性能稳步提升,SemiAnalysis的基准测试显示,自2025年10月以来,在某些交互级别下单GPU吞吐量翻了一番。硬件和软件进步的结合实现了英伟达所描述的:相比Hopper架构,每用户每秒token数提升10倍,每兆瓦每秒token数提升5倍,最终实现AI工厂输出的综合50倍增长。

CoreWeave公司工程高级副总裁Chen Goldberg表示:"随着推理成为AI生产的核心,长上下文性能和token效率变得至关重要。Grace Blackwell NVL72直接应对了这一挑战。"

云服务商大规模部署

各大云服务商迅速推进了 GB300 NVL72 基础设施的部署。CoreWeave 于 2025 年宣布成为首家在生产环境中部署该系统的 AI 云服务商,并将其集成到基于 Kubernetes 的云堆栈中。微软部署了其所称的全球首个大规模 GB300 NVL72 超算集群,在经 Signal65 验证的测试中,单个机架实现了每秒超过 110 万个 token 的处理速度。

甲骨文的 OCI 平台也在部署 GB300 NVL72 系统,计划将其超级集群扩展至超过 10 万个 Blackwell GPU,以满足推理工作负载日益增长的需求。

代币经济学重塑AI商业模式

成本的降低可能会重塑AI部署经济学。包括Baseten、DeepInfra、Fireworks AI和Together AI在内的领先推理服务提供商报告称,使用标准Blackwell平台可实现高达10倍的成本降低。Blackwell Ultra平台进一步扩大了这些优势,针对需要低延迟的工作负载,每百万代币降低35倍的成本,使得AI代理和编码助手的大规模部署在经济上更加可行。

英伟达已经预览了其下一代Rubin平台的进一步改进,该公司表示该平台将在Blackwell的基础上再提升10倍性能。